O FaceApp bombou esta semana mostrando como os usuários do aplicativo poderão ficar quando estiverem idosos. Mas a viralização do app também levantou discussões sobre como os dados das pessoas que se divertiram com os filtros podem ser utilizados pela empresa que desenvolveu essa tecnologia.

- Publicidades -

Além da questão da privacidade, outra polêmica em torno do assunto é o fato dessas tecnologias também carregarem o peso de reproduzir o racismo em diversas situações.

É o caso do próprio FaceApp que já tinha causado polêmica com o filtro “hot” que prometia deixar as pessoas mais atraentes. Esse filtro embranquecia a pele de pessoas negras e indianas.

Tarcízio Silva, doutorando em Ciências Humanas e Sociais da Universidade Federal do ABC (UFABC), pesquisa o racismo algorítmico e explica que “a desigualdade resultante de séculos de exploração se desdobra também em tecnologias do cotidiano” como as plataformas digitais, mídias sociais, aplicativos e inteligência artificial, que podem reproduzir e intensificar o racismo na sociedade.

Outros exemplos de racismo algorítimico

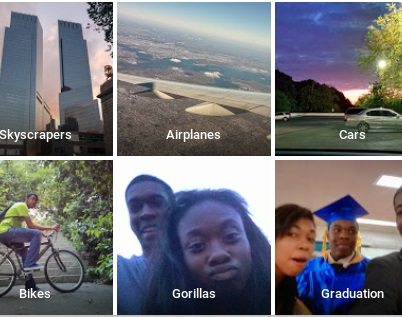

Em sua pesquisa de mestrado, Silva se dedicou a procurar exemplos de racismo que aconteceram no ambiente virtual, como o caso de mulheres negras que foram marcadas como gorilas no GooglePhotos.

Outro fato marcante foi protagonizado pelo Facebook. Usuários norte-americanos descobriram que a empresa de Mark Zuckerberg permitia a exclusão de pessoas negras e asiáticas dos anúncios de venda de casa.

A ferramenta, contudo, não possibilitava a exclusão de pessoas brancas. O problema ganha outra dimensão quando levamos em consideração que existe uma lei que proíbe a discriminação no mercado imobiliário nos EUA.

Silva destaca um exemplo ainda mais gritante. Em 2016, ficou comprovado que o algoritmo usado pelo sistema correcional dos EUA favorecia a liberdade de brancos, enquanto orientava que homens negros continuassem presos.

As causas do problema

O especialista apresenta três fatores principais que agem como causa-consequência para que o racismo se perpetue no meio tecnológico.

Segundo ele, em geral, não existe diversidade racial e cultural dentro das empresas que desenvolvem essas tecnologias. “Isto tem impactos nas plataformas e dispositivos pois, em consequência, abarcarão menos a diversidade de usos e usuários”, decreta.

Como não há pluralidade, os dispositivos e sistemas são criados e treinados por pessoas que não representam a sociedade e podem apresentar os comportamentos racistas registrados. É o que Silva classifica como omissão das empresas.

“A omissão é um problema relevante, uma vez que alguns sistemas problemáticos nem sequer foram testados corretamente antes de ir ao ar”, afirma.

Por fim, essas mesmas empresas vendem a falsa ideia de que “tecnologias são neutras”, para eliminar as responsabilidades pelo conteúdo racista propagado.

Reconhecimento facial e imigração

Muitos usuários do FaceApp levantaram a possibilidade de que as imagens armazenadas pelo aplicativo possam ser utilizadas depois em sistemas de reconhecimento facial. Para o doutorando, a possibilidade acende alertas.

“Eu defendo que as pessoas sejam cautelosas com procedimentos e aplicativos de processamento automático de conteúdo e inteligência artificial”, explica.

Grandes empresas como a Amazon possuem seus próprios softwares de reconhecimento facial, que já são utilizados por pequenas forças policiais há um custo de US$ 6,00 (cerca de R$ 22,00) por mês.

Além disso, no fim do ano passado, a empresa de Jeff Bezos confirmou que estava negociando a venda de dados do sistema Rekognition para a Agência de Imigração e Alfândega dos EUA (ICE na sigla em inglês). A ICE é a responsável pela fiscalização da imigração irregular nas fronteiras dos EUA.

Erros no reconhecimento facial

Os softwares de reconhecimento facial, contudo, não estão isentos de erro. Muito pelo contrário. A situação é mais preocupante em casos de minorias como latinos, negros, árabes e asiáticos, que correm maior risco de ser confundidos.

No Reino Unido, um relatório independente publicado no início do mês demonstrou que 81% dos “suspeitos” identificados pela tecnologia usada pela Polícia Metropolitana na verdade eram inocentes.

Até mesmo no Rio de Janeiro, onde sistemas semelhantes passaram a ser usados há pouco tempo, já houve caso de identificação errada.

Testes feitos com carros autônomos mostraram que há maior possibilidade de que pessoas negras não sejam reconhecidas pelas câmeras do veículo e sejam atropeladas.

Sou de Palmas, informação de qualidade e credibilidade em primeira mão! Quer sugerir ou receber nosso conteúdo? Entre em contato com nossa equipe.

Zap (63) 99223 7820

FAÇA PARTE DA NOSSA REDE!

Facebook: https://m.facebook.com/SouDePalmasNoticias/?locale2=pt_BR

Twitter: @SouDePMW

Email: [email protected]